23 settembre 2015 11:42

Migrazione di un Sistema Informativo nel Cloud: esperienze reali

Disclaimer: NON SONO UN SISTEMISTA!

I sistemisti veri, quelli seri e bravi magari storceranno il naso leggendo alcune affermazioni oppure le riterranno banali e scontate. Nella mia società svolgo ANCHE questo ruolo condiviso con quello di developer, software architect, dba, marketing- media- e quality assurance manager (!) Il post ha lo scopo quindi, oltre che per mia documentazione storica, di convincere i dubbiosi che il porting di un sistema informativo nel cloud può essere affrontato anche senza disporre di un ufficio IT con N addetti ma semplicemente organizzandosi e documentandosi un pochino.

All'inizio dell'anno, conscio della fine del supporto di Windows Server 2003 avvenuto il 14 luglio, sistema operativo che equipaggiava con soddisfazione ancora la metà dei miei server, ho cominciato a pensare a un rinnovamento del sistema informativo della mia azienda. Da 7 anni ad oggi la nostra piccola server farm era basata su hardware IBM (Blade Center H, SAN DS4700) e ambiente Vmware ESXi 5.5, oltre che infrastruttura di rete e firewall Cisco. A parte un ultimo anno disastroso per una issue mai risolta sulla Tape Library TS3200 (definirla insieme al software Tivoli "enterprise" è ridicolo se salta 2 backup al mese per un blocco hardware che non riescono a risolvere), devo solo rendere onore all'affidabilità e la continuità di servizio fornita da Big Blue.

All'inizio dell'anno, conscio della fine del supporto di Windows Server 2003 avvenuto il 14 luglio, sistema operativo che equipaggiava con soddisfazione ancora la metà dei miei server, ho cominciato a pensare a un rinnovamento del sistema informativo della mia azienda. Da 7 anni ad oggi la nostra piccola server farm era basata su hardware IBM (Blade Center H, SAN DS4700) e ambiente Vmware ESXi 5.5, oltre che infrastruttura di rete e firewall Cisco. A parte un ultimo anno disastroso per una issue mai risolta sulla Tape Library TS3200 (definirla insieme al software Tivoli "enterprise" è ridicolo se salta 2 backup al mese per un blocco hardware che non riescono a risolvere), devo solo rendere onore all'affidabilità e la continuità di servizio fornita da Big Blue.

Ero già a buon punto con le trattative per un rinnovo dell'impianto (lame nuove, San Storwize v7000 nuova, passaggio a Win2012R2 di tutto, ecc.) quando durante una visita di un commerciale del nostro provider di connettività Internet, mi venne buttata lì la proposta "ma perché non metti tutto in outsourcing da noi nel nostro Cloud center?" Non che non ci avessi mai pensato ma conoscendo la nostra attività di progettazione basata su file CAD 3D pesanti, tonnellate di file word altrettanto grossi pieni di grafici foto e formule e comunque di un traffico client-server di una trentina abbondante di postazioni, la necessità di un back-bone "largo" era imprescindibile. "Che problema c'è? Abbiamo già la fibra, ti diamo 1 Gbit di connessione in MPLS tra la sede e il nostro datacenter…". La cosa cominciava a farsi interessante, ora c'erano solo da capire la qualità del servizio e i costi.

Sul primo fattore avevo già avuto modo in passato di visitare il bCloud Center di Brennercom e ne ero rimasto molto ben impressionato: hardware Cisco, storage EMC2, ambiente Vmware vCloud, sistemi anti-incendio, anti-intrusione, ups con standard elevatissimi, certificazione CIS ISO/IEC 27001, insomma all'apparenza tutto perfetto. Dopo i primi colloqui tecnici ho avuto anche l'impressione di trovarmi di fronte a persone molto competenti e skillate. Dopo un mese di ambiente test datoci in prova (fattore assolutamente da non sottovalutare il fatto di testare con benchmark se la soluzione fa per voi) la mia parte techno-geek-nerd era completamente convinta, non solo per le prestazioni -la linea MPLS testata con un apparecchio dedicato alla fibra ha fornito sempre 997Mbit di average throughput quindi il Gbit era reale!- ma anche per la facilità e autonomia di gestirsi le cose via browser tramite il vCloud Director, praticamente una versione web-base del vSphere Client che avevo fin qui usato.

Restava ora da capire se i canoni annuali da pagare fossero sostenibili oppure "bello bello ma costa troppo". Ebbene, non so nel resto d'Italia 1 gbit di fibra costi così, ma alla fine la somma di quello che pagavo di contratti di manutenzione a IBM, Vmware, Cisco, vari software di backup (Tivoli, AvePoint) unitamente al risparmio di corrente e della connessione internet HDSL che avevamo (visto che adesso navighiamo tramite il cloud con una 50Mbit simmetrica) si è rivelata praticamente uguale o poco inferiore al canone del datacenter. Con però ovviamente un'infinità di vantaggi: maggiore scalabilità (due click e aggiungo cpu, ram, storage), nessuna preoccupazione per gli upgrade firmware o di vmware che dovevo fare ogni anno, nessuna obsolescenza dell'hardware, basta borse piene di tape LTO da portarsi a casa ogni sera e soprattutto maggiore affidabilità e tanti 9 in più agli SLA che il mio armadio poteva offrire: il mio UPS durava 15 minuti il loro giorni, il mio anti-incendio è un SMS mandato dal rivelatore di fumo il loro un sistema schiumogeno avanzatissimo, io ridondavo su un disco usb da pochi euro, loro mirrorano tutto il datacenter a Trento e Innsbruck, ecc. ecc.

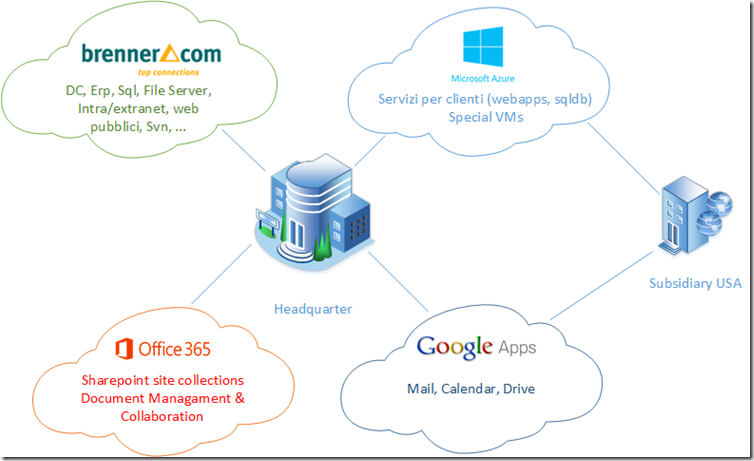

A inizio agosto, contando sulle due settimane di semi-chiusura aziendale è partita quindi la migrazione, non solo verso il bCloud di Brennercom ma spostando alcuni servizi anche su cloud provider diversi. Sulla piattaforma Microsoft Azure in particolare abbiamo messo servizi destinati ai clienti (Sql Databases, siti web e servizi wcf/rest/json) in quanto necessitavano di maggior vicinanza geografica al cliente stesso (East Asia) e un scalability "elastica" dovendo supportare servizi stagionali e limitati nel tempo (in pratica durante i 4 mesi di gare devono essere pompati, mentre per 8 mesi sono quasi in idle, e per questo il business model di Azure pay-as-you-consume è imbattibile). Stesso discorso per alcune virtual machines destinate alla nostra subsidiary americana (messa in East USA e quindi per loro molto più veloce) o di vm che ci servono per poche ore di calcolo/compilazione ma con risorse estremamente pompate (una G5 da 32 core e mezzo Tb di ram costa 8€/ora, che può sembrare tanto ma è infinitamente di meno se dovessi comprare un hardware anche solo 1/10 meno potente e metterci 10x del tempo a risolvere il mio problema).

La gestione documentale dei nostri progetti è da sempre stata affidata a Sharepoint che non avevo ancora upgradato al 2013 viste le esosissime risorse hardware necessarie e che tenevo ancora on-premise nonostante le esortazioni degli amici Igor e Paolo a passare alla versione online su Office365. La cosa più difficile è stato capire la differenza tra il prodotto Sharepoint Online e la parte Sharepoint compresa in una delle edizioni Office 365 Business: un classico esempio di inutile complicazione quando si offrono prodotti simili che disorientano l'utente. Alla fine, visto che al momento eravamo già coperti dalle licenze Office2013 acquistate in-the-box o come OEM insieme ai pc, abbiamo optato per una Business Essential da 4,2€/mese che offre già 10Gb di spazio Sharepoint più 500Mb per ogni utente (lo spazio aggiuntivo comunque costa un'inezia 0,17€/mese/Gb). Qui il risparmio è enorme in quanto Microsoft (che forse ha fatto male i suoi conti!) dà la possibilità di usare i cosiddetti "external users". In pratica se lo scopo è solo quello di usare i portali sharepoint e di non avvalersi degli altri servizi di Office365 (mail, active directory, skype for business, ecc.) si può creare solo un utente admin e invitare gli altri fruitori del portale di collaboration (interni o esterni) tramite un loro account microsoft senza dover pagare nessuna licenza. Mi sono letto n volte le eula e chiesto conferma a chi ne sa più di me e pur "vergognandomi" –mi sembrava di essere il solo italiano che sfrutta una scappatoia- con meno di 10€/mese ho i miei 40Gb di contenuti organizzati in varie site collections, con i diritti assegnati tramite Groups, ecc. Una vera manna! (per la migrazione, vedi sotto).

L'upgrade alla versione Premium (con Office desktop, la mail, gli utenti autenticati con il loro account AD) è comunque una cosa prevista per il 2016, in quanto l'esperienza d'uso integrata penso ripaghi il costo leggermente superiore delle Google Apps che attualmente stiamo usando.

Ecco quindi la nostra situazione attuale "cloud-based"; di seguito alcune note e tool usati durante l'intenso periodo di migration.

Progettare, testare, documentare

Sembrerà una ovvietà ma tutto deve partire da una buon pianificazione delle attività. Non sto parlando di scrivere tonnellate di procedure con timing al minuto e check-list infinite ma soprattutto di fare uno screening preciso di tutti i servizi esistenti che nel corso degli anni si sono accumulati e che vanno trattati. Se le macro-azioni e le loro dipendenze sono evidenti (devi spostare prima i Db Sql dei siti web che vi si appoggiano!) sono le piccole cose che sembrano più marginali che vanno trattate con attenzione. Ti ricordavi di quel servizio che gira su quel recondito server che prende i dati del lettore di badge controllo presenze e scrive i dati in quella tabella con 3 trigger che manipolano i dati? Ho ancora il CD dell'installer? Il servizio funzionerà su una macchina x64? La ditta che ce l'ha installato 10 anni fa esiste ancora? Che porte tcp devo aprire? Come faccio a cambiare l'IP dentro il reader? E questo è solo un piccolo esempio, di queste cose un'infrastruttura IT è piena e se non si fa lo sforzo iniziale di un buon censimento e di come trattare tutti i casi, ci si frega con le proprie mani.

Sembrerà ovvio dirlo, ma la fase di testing è necessaria o fondamentale. Anche se non avete voglia o possibilità di mettere in piedi un ambiente di staging o di test vero e proprio, prendete un PC che non sia il vostro e simulate più casi possibili dei cambiamenti che andrete a fare.

Ah…se fra 7 anni non vorrete trovarvi nelle stesse condizioni di cui sopra, documentate il più possibile la vostra infrastruttura e i tutti i trick che avete adottato nella fase di migrazione.

Tools & Tips

Ognuno degli argomenti qui sotto trattati meriterebbe un post a sé stante, ma ho preferito riunirli tutti qui per un quadro più completo.

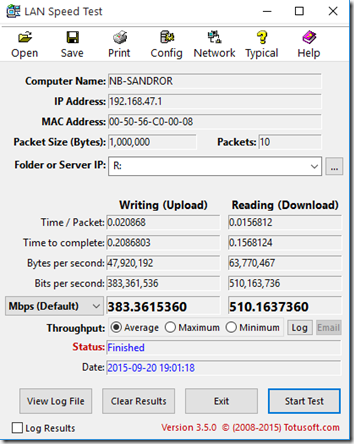

Lan Speed Test benchmark

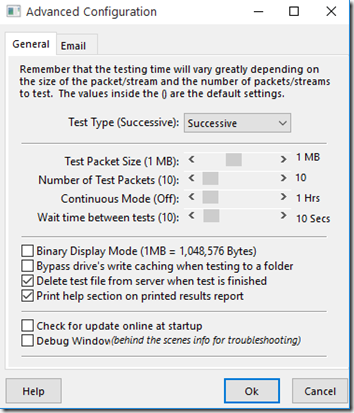

Come dicevo poco sopra, durante il periodo di prova che mi era stato concesso, la mia maggior preoccupazione è stata quella di testare a dovere se le prestazioni del file server fossero simili alla soluzione on-premise e a parte test empirici fatti con file-copy (sia da codice C# che da window explorer che da robocopy), volevo qualcosa di più specifico. Ho trovato in questo software (Lan Speed Test di TotusSoft) un ottimo tool che permette di verificare le performance della rete e del file server. Investite la pazzesca cifra di 6$ e comprate la versione full in quanto solo con questa si ha disposizione la parte "server" del software da lanciare sul nodo remoto e che si mette in ascolto del client su una specifica porta. In questo modo si misurano veramente solo le performance della rete tralasciando la parte relativa alla scrittura su disco. Se invece si testa l'effettiva scrittura dei file è possibile disabilitare la write cache del disco per non venir ingannati da risultati eclatanti che non sono merito della rete ma dello storage. Comodo anche il fatto di poter simulare copie di file molto piccoli o molto grandi (si sceglie la file size e il numero di pacchetti da mandare). Così come per statistiche serie la possibilità di far girare il tool per molte ore e controllare la media e i logs alla fine.

Ho avuto modo di testare anche il loro support e hanno risposto in modo veloce ed esaustivo (e per un programma da 6$ non sempre è scontato). Con una rete da 1Gbit i risultati dovrebbero essere di 8/900 Mbps con LST Server (in entrambe le direzioni) e di 400/500 Mbps su una shared folder. Se i valori sono molto inferiori indagate sul perché (ad esempio nel mio caso all'inizio lo erano, e si è rivelato essere un impostazione del driver della mia scheda di rete in cui l'Auto-mode non abilitava il full-duplex a 1Gbit).

Forensit User Profile Wizard

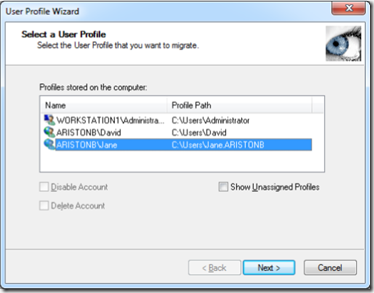

Durante la fase di pianificazione e progettazione, uno dei dubbi emersi fin da subito era se mantenere il vecchio Active Directory (facendo un nuovo domain controller nel cloud e promovendolo con "dc promo" quando necessario) o farne uno nuovo. La seconda soluzione mi attirava molto perché il vecchio AD aveva accumulato negli anni decine di gruppi e utenti non più necessari e il tempo per fare pulizia sarebbe stato simile a un dominio vergine. Inoltre molti username, essendo stati creati prima del mio arrivo nel 2008, non avevano il pattern NomeC che prediligo per gli account (es. Roby invece che RobertoB) e se c'è una cosa che odio sono gli ambienti misti dove non esiste una standardizzazione unica.

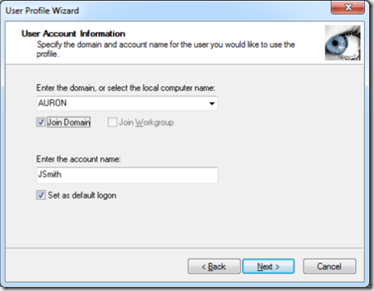

Il problema di creare un nuovo dominio era però dato dai profili utenti dei PC client che avrebbero dovuto essere ricreati da zero: stampanti, driver, reinstallazioni di software, cose che andavano prima e poi magari avrebbero smesso, ecc. Se non avessi trovato il tool User Profile Wizard di Forensit che svolge proprio questo compito (migrare i profili utenti da un dominio all'altro), probabilmente mi sarei tenuto il vecchio dominio, ma le prove con la versione free erano incoraggianti.

Anche qui abbiamo diverse versioni: la free funziona già benissimo ma non consente il salvataggio di un config e quindi bisogna per ogni PC dare ogni volta tutti i dati, mentre con le versioni a pagamento si può automatizzare molto la migrazione di molti profili (con la Corporate addirittura via GPEdit l'utente si logga, viene migrato, joined al nuovo dominio, reboot ed è a posto… con reti da migliaia di client una panacea!). A me bastava la Professional in quanto avevo comunque intenzione di fare l'operazione sulla singola workstation per verificare il buon esito ma non avevo voglia di ridigitare i dati necessari per 40 volte! Inoltre, ho pensato, se mi succede qualcosa con la versione a pagamento posso usufruire del supporto, mentre con la free solo dei forum pubblici (illuso, vedi sotto).

Inoltre le versioni a pagamento avevano un'altra feature che mi serviva, ovvero quella di rinominare la directory dello user compatibilmente con il nuovo account name; quindi un utente OldDomain\Roby sarebbe diventato NewDomain\RobertoB e la sua c:\users\Roby rinominata c:\users\RobertoB con tutte le conseguenze del caso (le varie Documents, Pictures, ecc settate correttamente, cambiato nel registry i vari path, ecc.)

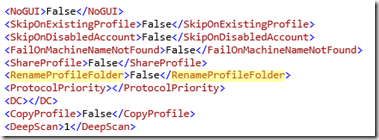

Dopo i primi utenti in cui tutto era filato liscio, ho avuto delle problematiche con Outlook 2013 e 2010 (profili che non si ricaricavano più, auto-creazioni di nuovi profili vuoti di default, ecc.) Fortunatamente tutti gli Outlook erano settati con Imap e quindi è bastato cancellarli e ricrearli. In qualche altro caso alcune cartelle di Matlab nella appdata non sono riuscite ad applicare le ACL al nuovo SID rinominato, ed anche qui è bastato un take ownership e ri-assegnazione di diritti. Comunque sia, l'opzione RENAMEPROFILEFOLDER non è assolutamente affidabile e sconsiglio vivamente di usarla. In aggiunta a ciò il tanto sperato supporto che avrei dovuto ricevere dietro il pagamento della licenza si è rivelata assolutamente inefficiente e menefreghista… l'unica risposta è stata "non ci risulta che non funzioni, quell'opzione è lì da anni ed è sempre andata bene". Nessuna risposta ai miei screenshot dove gli dimostravo che N migrazioni di workstation diverse con N versioni di Outlook erano fallite.

(lo scrivo anche in inglese se qualcuno lo cerca con google)

The Rename Profile Folder of Forensit User Profile Wizard Professional Edition is IMHO extremely UNRELIABLE. It has destroyed on several PCs the Outlook profiles in many conditions:

- Outlook 2013 with Imap: account corrupted

- Outlook 2013 with Google Apps Sync (Mapi): outlook stucked with “Loading Profile…”

- Outlook 2010 with Pop: at first start it ask to relaunch the program; at second launch mailbox is visible but send/receive says Outlook Data File cannot be accessed

- Outlook 2010 with Imap: it creates a xxx(2).pst and an outlook.pst doing a mess…

Morale della favola: il tool fa il suo lavoro ed è irrinunciabile se dovete migrare profili da un dominio all'altro o rinominare workstation. Se non avete un numero considerevole di postazioni, il mio consiglio è di risparmiare soldi e usare la versione free.

PowerShell

Chiamarlo Tool è molto riduttivo. Ogni sistemista immagino lo padroneggi a menadito, ma a mio avviso andrebbe imparato anche dagli sviluppatori così come dai cosiddetti Power Users. Così come noi utenti vecchietti sapevamo destreggiarsi con i pochi comandi della shell Dos (for %i, errorlevel, ecc.) oggi un utente che si vuole definire esperto di PC dovrebbe avere nel suo bagaglio l'uso di questo straordinario strumento arrivato alla versione 4.0.

Nell'ambito della mia migrazione mi è stato utilissimo per la creazione degli account di Active Directory, per la creazione di net share con determinate caratteristiche (es. per ogni utente di AD crea una folder NomeC, crea una Share NomeC$, assegna le ACL e i share permission giusti, ecc.). Tutte cose automatizzabili che evitano operazioni noiose e facili da sbagliare (alla decima operazione uguale si viene presi dalla noia e si compiono molto più facilmente errori). Inoltre automatizzare tramite script delle operazioni consente di lanciarle N volte (es. su ambienti di test o anche solo cancellando tutto e rifacendo l'operazione).

Il bello è lavorare partendo da un file CSV (quindi da excel) dove potete mettere tutti i dati dei vostri utenti che dovete creare e poi con un elegante comando e sintassi si possono enumerare le varie righe e dare i comandi di import (qui e qui trovate due ottimi esempi) o ad esempio di change password al next logon…

Import-Csv "C:\Scripts\UserList.csv" | ForEach-Object {

New-ADUser $sam -GivenName $_.GivenName -Initials $_.Initials

...

}

$CghPwd = $true

Import-Csv "C:\Scripts\UserList.csv" | ForEach-Object {

Set-ADUser –Identity $_sam -ChangePasswordAtLogon $CghPwd

}

Copia del File Server

Ancora una volta il consiglio è quello di progettare preventivamente e cogliere l'occasione per una bella riorganizzazione di utenti, gruppi, diritti, OU e quanto altro. Prendetevi carta, penna (o excel con una bella pivot table) e fatevi una mappa di quali e quanti gruppi vi servono (Management, Developers, Accounting, TechLab, ecc.) ed assegnate per bene le ACL a share e cartelle secondo la nuova mappa cercando di usare più possibile la Inheritance della cartella parent. NON assegnate MAI diritti su un singolo user ma sempre a un gruppo (io faccio un gruppo anche per un solo utente e non me ne sono mai pentito).

Per la copia di grandi quantità di files non è buona norma usare il classico Windows Explorer in quanto un file locked ne fermerebbe il processo e soprattutto è facile che ci serva fare una prima copia e poi al go-live copiare solo quello che nel frattempo è cambiato. Tool di sincronizzazione ne esistono a decine, in passato usavo quello free di Microsoft (SyncToy 2.01) mentre ora il più completo e professionale SyncBack Pro. Va comunque benissimo anche il tool da riga di comando robocopy che con l'opzione /MIR mirrora un intero directory tree . Le opzioni che di solito uso sono

robocopy <source> <target> /MIR /Z /W:5 /fft /xo

Script Sql

Migrare una ventina di database Sql da un server all'altro (tra l'altro con doppio salto di upgrade di versione da 2008 a 2014) richiede un attimo di attenzione. Le strade, come ben sanno i DBA sono due: Detach e Attach oppure Backup e Restore. In entrambi i casi il mio consiglio è quello di non fare mai le operazioni con la GUI grafica di Sql Management ma di prepararsi preventivamente gli script sql per i succitati motivi (test, reuse, ecc.)

Ad esempio questa query vi permette di estrarre alcuni dettagli dei vostri databases (i primi 4 sono solitamente quelli di sistema, la where è un po' artigianale, dateci un occhio…) e vi permette di creare gli script di backup, restore, copy, drop, ecc.

select

d.name as 'database',

mdf.physical_name as 'mdf_file',

ldf.physical_name as 'log_file'

from sys.databases d

inner join sys.master_files mdf on

d.database_id = mdf.database_id and mdf.[type] = 0

inner join sys.master_files ldf on

d.database_id = ldf.database_id and ldf.[type] = 1

WHERE d.database_id>4

Prima di attachare o restorare i db sul nuovo server vanno ovviamente create le Sql Login (sarebbe bello e più sicuro usare sempre l'Integrated Security ma purtroppo non sempre è possibile). Se non volete impazzire a fixare users orfani (la famosa sp_change_users_login AUTO_FIX) utilizzate questo metodo oppure più semplicemente estraete i SID dei vostri vecchi login (SELECT name, sid FROM syslogins) e poi create sul nuovo server i login con i sid estratti

CREATE LOGIN [mylogin] WITH PASSWORD=N'mypassword',

SID=0x417410CE04CDFB4296AF4AAAB4404348,

DEFAULT_DATABASE=[master],

CHECK_EXPIRATION=OFF,

CHECK_POLICY=OFF

Già che ci siete una volta restorati i DB sul nuovo server verificate e uniformate (settandoli con una serie di ALTER DATABASE) la COMPATIBILITY_LEVEL (120 per Sql 2014), le opzioni di AUTO_CLOSE e AUTO_SHRINK (io le tengo su off), la PAGE_VERIFY (checksum) e il RECOVERY mode (simple o full a seconda di come siete abituati a trattare il backup dei log).

Non dimenticate ovviamente di ri-creare linked server, jobs di Sql agent, maintenance plans, operators e alerts per gli avvisi via mail, ecc, ecc. Più informazioni salvate in script sql, meno lavorerete la prossima volta.

Migrazione dei dati di Sharepoint

Come molti sapranno "fare l'upgrade" di una piattaforma Sharepoint non è così semplice (anzi) come per altri prodotti. Molte volte si tende a installare ex-novo la nuova versione e poi migrare i contenuti dalla vecchia alla nuova. Ecco perché sono nati molti tool di terze parti che affrontano questo delicato argomento. Cercando "how to migrate sharepoint content" su google saltano fuori decine di links, whitepapers, top lists come questa, ecc. Il mio obiettivo era di migrare i contenuti di 3 sitecollections con una ventina di siti (un paio ne avevano molti di più –un Basic Meeting Subsite per ogni ruinione- ma li ho aggregati in un'unica Doc Library) dal mio Sharepoint 2010 On-Premise alla 2013 di Sharepoint Online di Office365.

Inizialmente ero pronto a investire in AvePoint, società produttrice del prodotto di Backup (DocAve) che ho usato con soddisfazione negli ultimi anni. Purtroppo il loro prodotto di migration non si capisce in che cavolo di suite sia integrato, se bisogna essere abbonati ad una subscription, se esiste una trail, ecc. Insomma dopo qualche mail scambiata col loro sales support mi sono arreso e ho virato su altri due prodotti

Share-Gate

Ecco invece una landing fatta come si deve: pochi contenuti, tanta informazione in un colpo solo. Sharegate è sicuramente un ottimo prodotto; ha una user-interface chiarissima e facilissima da usare e capire e in 2 minuti si è pronti a copiare i contenuti da un sito all'altro. Il loro supporto pre-sale è disponibilissimo e al limite dell'estenuante (mi avranno scritto 100 mail, come sta andando l'evaluation, se avevo bisogno di prolungare il periodo, se volevo un webinar, ecc, ecc.). La versione Trail ha un limite molto particolare: copia senza limitazioni tutto quello che gli si dice ma… "When using the trial, some items and documents may be randomly skipped". Durante i miei test non ha mai saltato nessun item, certo è che con quella spada di Damocle sulla testa uno non può certo usarla in produzione. Difetti? Se non ci fossero altre alternative più economiche (o free) non ne avrebbe, purtroppo per loro i competitors sono più aggressivi e il loro prezzo da 2 a 4000$ lo rende (per, ricordiamoci, un'operazione una-tantum) un prodotto un po' caro.

Metalogix Content Matrix

L'altro prodotto che ho messo sotto test in shoot-out col precedente è stato Content Matrix di Metalogix. Qui invece la UX/UI sembra essere stata disegnata da un buontempone che si diverte a scombinare le cose e a cercare di incasinarti la vita nel tentativo di capirci qualcosa: ad esempio se presenti due panes stile explorer a destra o sinistra uno è abituato fin dai tempi delle Norton Commander (!) ad avere source e target nelle due metà… qui invece puoi mettere entrambi tutti e due a sx (o dx). Perchè ?? Idem per il multiselect… c'è un checkbox vicino a ogni item, ma puoi usare il CTRL e fare multiselezione e funziona lo stesso… Ma allora cosa serve il checkbox ?? Mah!

Comunque sia, il suo lavoro di copia contenuti lo svolge egregiamente, così come il mapping degli utenti, dei terms nei managed metadata, dei subsites, ecc. Il costo è uguale al concorrente (da 2 a 4000$) ma ha un grossissimo vantaggio: la versione Trial consente la migrazione free di 10 Gb di dati, ed in più esiste una versione free (la cosiddetta Content Matrix Migration Express) che te ne regala altri 25. Insomma se avete meno di 35Gb di dati e la migrazione è semplice così da non aver presumibilmente bisogno del loro support, siete a cavallo.

Come ultima chicca di questa soluzione, segnalo un interessante tool free (Migration Expert) che può essere molto utile in fase di preparazione della migrazione. Vi analizza infatti la vostra farm e vi mette in guardia da eventuali possibili issues o incompatibilità che potreste trovare successivamente. A me ad esempio ha segnalato alcuni vecchi subsites dimenticati basati su templates obsoleti (i Fab 40s).

Conclusioni

Dubito che qualcuno sia arrivato in fondo a questo lunghissimo post, nel caso bravi! Come alla fine di un libro sono d'obbligo alcuni ringraziamenti. In primis a tutto lo staff di Bitech che in questi 7 anni ci ha meravigliosamente supportato sia a livello commerciale (grazie Alessandro) che soprattutto tecnico. Lo skill sistemistico degli ambienti Windows Server, Vmware, IBM e Cisco di Roberto e Tiziano (ma immagino anche dei loro colleghi) è uno dei più alti che io abbia incontrato in tutta la mia lunga carriera nel settore IT. Real Guru! Grazie anche a Michele che in quest'ultimo anno ce l'ha messa tutta per risolvermi il problema della tape library e per rendermi meno ostico l'ambiente Tivoli. E unitamente a questo mi preme ricordare la loro infinita disponibilità e cortesia (rispondere al cellulare alle 23, nel w/e o durante le loro ferie non sarebbe nei loro compiti, ma non si tirano mai indietro). Se avete bisogno di un partner serio, efficiente e preparato con loro siete in ottime mani (ed infatti la nostra collaborazione continuerà per i client e per le soluzioni destinate ai nostri clienti.)

E grazie anche ai nuovi partner di Brennercom sia quelli dietro alle quinte che hanno inizializzato il sistema (le vlan, i routing, il vCloud) sia soprattutto i security engineers -cito Pietro con cui ho avuto più a che fare, ma anche i suoi colleghi- che mi hanno dato un enorme aiuto nella configurazione del firewall, della vpn e della security in generale.

Spero che il post possa servire a qualche responsabile IT per convincere il suo management che il passaggio nel cloud è fattibile, non è così costoso come si immagina (non più della soluzione on-premise comunque) e ha moltissimi vantaggi. Se la Direzione ha i soliti dubbi sul fatto che "i miei dati sono in mano ad altri…" convinceteli che nei datacenter esterni c'è molta più RAMS (Reliability, Availability, Maintainability and Safety dove l'ultima S la sostituirei con Security) che non in-house.

E poi ricordiamoci i corsi e ricorsi storici… quando iniziai a lavorare nel 1988 la mia società aveva in casa un enorme Honeywell Bull DPS e forniva ai nostri clienti, collegati al max a 9600 o 19200 baud, storage e computing per il gestionale… Tutto gira, tutto torna!

UPDATE

A distanza di quasi un anno, Brennercom mi ha chiesto di presentare in un breve video la nostra case-history, illustrata qui sopra.